🇨🇳中文预训练模型研究进展&整理

https://www.jsjkx.com/CN/article/openArticlePDF.jsp?id=20915

近两年,中文预训练模型受 到广大学者的关注并取得了一定的研究成果.为了阐明现有 的中文预训练模型,本节主要从以下6个方面对现有的预训练 模型进行分类,图3展示了典型的中文预训练模型的分类图.

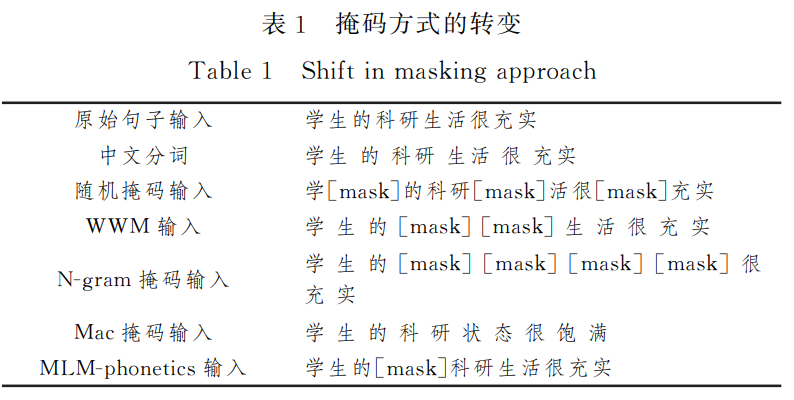

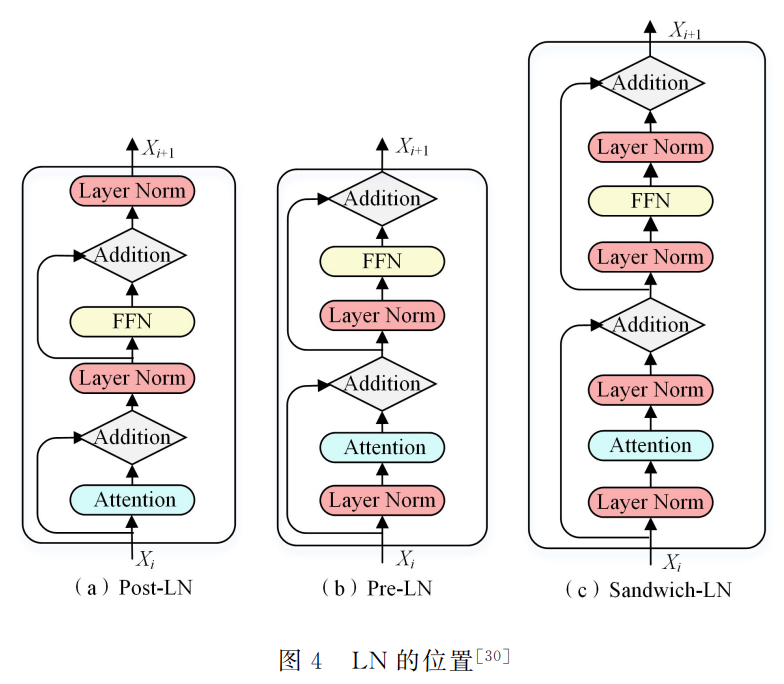

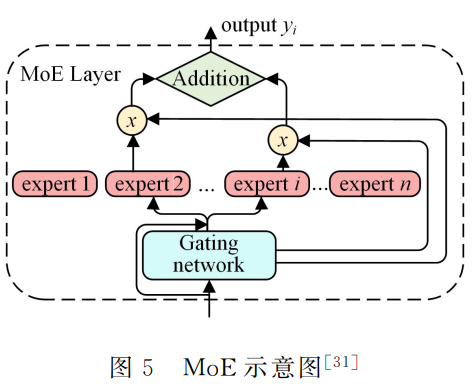

- 预训练模型的方法改进,主要包括掩码方式的转变、 位置编码的转变、LN 层的位置变化、MoE 层的使用、多粒度训练和其他改进.

- 融入外部信息的预训练,主要包括命名实体、知识图 谱、语言学知识和特定知识.

- 关于多模态融合的预训练模型.

- 侧重于高效计算的预训练,主要包括数据处理阶段、 预训练阶段以及技术优化.

- 指特定领域的预训练,主要包括对话系统和其他领域 的预训练模型.

- 介绍一些其他变体,主要侧重于典型的英文预训练模 型开源的中文版本.

开源的中文预训练模型汇总

NLU系列

| 模型 | 版本 | 作者 | 源地址 | 应用领域 |

|---|---|---|---|---|

| ChineseBERT | base | ShannonAI | github | 通用 |

| NEZHA-base | base | HUAWEI | github | 通用 |

| MacBERT-base | base | Yiming Cui | github | 通用 |

| WoBERT | base | ZhuiyiTechnology | github | 通用 |

| WoBERT-plus | base | ZhuiyiTechnology | github | 通用 |

| ZEN-Base | base | Sinovation Ventures AI Institute | github | 通用 |

| ernie-3.0-base | base | PaddlePaddle | github | 通用 |

| roformer | base(L12) | ZhuiyiTechnology | github | 通用 |

| roformerV2 | base(L12) | ZhuiyiTechnology | github | 通用 |

| LatticeBERT | base(L12) | Alibaba | github | 通用 |

| Mengzi-BERT | base(L12) | Langboat | github | 通用 |

| bloom-6b4-zh | 6B(L30) | Langboat | github | 通用 |

| TaCL | base(L12) | yxuansu | github | 通用 |

| chinese_GAU-alpha-char_L-24_H-768 | base | ZhuiyiTechnology | github | 通用 |

| pai-ckbert-base-zh | base | Alibaba | github | 通用 |

| Chinese-LERT-base | 400m | Yiming Cui | github | 通用 |

NLG系列

| 模型 | 版本 | 类型 | 源地址 | 应用领域 |

|---|---|---|---|---|

| CDial-GPTLCCC-base | base | GPT | CDial-GPT | 中文对话 |

| roformer-gpt | base(L12) | GPT | github | 通用 |

| NEZHA-Gen | base | GPT | github | 通用 |

| CPM | 26亿参数 | 项目首页 | github | 通用 |

| Mengzi-T5 | base(L12) | T5 | github | 通用 |

| 盘古α-2.6B | 2.6G | 项目首页 | github | 通用 |

| EVA2.0-base | base | 项目首页 | github | 中文开放域对话 |

| BART-base | base | Seq2Seq | github | 中文通用 |

| Wenzhong | large(L24) | GPT2 | IDEA-CCNL | github |

| Yuyuan | large(L24) | GPT2 | IDEA-CCNL | github |

| ChatYuan | large | T5 | ClueAI | github |

NLU-NLG系列

| 模型 | 版本 | 作者 | 源地址 | 应用领域 |

|---|---|---|---|---|

| SimBERT Base | base | ZhuiyiTechnology | github | 通用 |

| roformer-sim | base(L12) | ZhuiyiTechnology | github | 通用 |

| roformer-sim-v2 | base(L12) | ZhuiyiTechnology | github | 通用 |

| Zhouwenwang | roformer | - | - | - |

| base(L12) | huggingface | github | 中文通用 | - |

| CPM-2 | 110亿参数 | BAAI-WuDao | github | 通用 |

| CPT-base | base(L12) | fastNLP | github | 通用 |

| OPD | 6.3B | thu-coai | github | 中文开放域对话 |

LLM

大规模语言模型:表格中只罗列出参数量大于10B以上模型。

| 模型 | 大小 | 结构 | 语言 | 下载 | 机构 | 项目地址 | 时间 | 文献 |

|---|---|---|---|---|---|---|---|---|

| flan-ul2 | 20B | encoder-decoder | 多语言 | ckpt | ul2 | 2023-03 | paper | |

| CPM-Bee | 10B | Decoder | 中英文 | 待发布 | OpenBMB | CPM-Live | 2023-01 | - |

| BLOOM | 176B | Decoder | 多语言 | ckpt-95000 | BigScience | Megatron-DeepSpeed | 2022-11 | paper |

| BLOOMZ | 176B | Decoder | 多语言 | ckpt-498 | BigScience | Megatron-DeepSpeed | 2022-11 | paper |

| flan-t5-xxl | 11B | encoder-decoder | 多语言 | ckpt | t5x | 2022-11 | paper | |

| CPM-Ant+ | 10B | Decoder | 中英文 | ckpt | OpenBMB | CPM-Live | 2022-10 | blog |

| GLM | 130B | Decoder | 中英文 | 申请下载 | 清华大学 | GLM-130B | 2022-10 | paper |

| CPM-Ant | 10B | Decoder | 中文 | ckpt | OpenBMB | CPM-Live | 2022-09 | blog |

| GLM | 10B | Decoder | 中文 | ckpt | 清华大学 | GLM | 2022-09 | paper |

| 源1.0 | 245B | Decoder | 中文 | API申请 | 浪潮 | Yian-1.0 | 2021-09 | paper |

| CPM-2 | 11B | encoder-decoder | 中文 | 申请下载 | 智源研究院 | CPM | 2021-06 | paper |

| CPM-2 | 10B | encoder-decoder | 中英文 | 申请下载 | 智源研究院 | CPM | 2021-06 | paper |

| PanGu-Alpha | 13B | Decoder | 中文 | ckpt | 鹏城实验室 | PanGu-Alpha | 2021-05 | paper |

| PanGu-Alpha | 200B | Decoder | 中文 | 待发布 | 鹏城实验室 | PanGu-Alpha | 2021-05 | paper |

| PLUG | 27B | encoder-decoder | 中文 | 申请下载 | 阿里巴巴 | AliceMind | 2021-04 | - |

| GPT-3 | 13B | Decoder | 中文 | 待发布 | 达摩院 | GPT-3预训练生成模型 | 2021-04 | - |

| GPT-3 | 30B | Decoder | 中文 | 待发布 | 达摩院 | GPT-3预训练生成模型 | 2021-04 | - |

ChatLLM

具备问答和对话等功能的大型语言模型。

| 模型 | 大小 | 结构 | 语言 | 下载 | 机构/个人 | 项目地址 | 时间 |

|---|---|---|---|---|---|---|---|

| ChatLLaMA | 7B | Decoder | 多语言 | ckpt | Li Yudong | Chinese-ChatLLaMA | 2023-03 |

| Chinese-Vicuna | 13B | Decoder | 中文 | ckpt | Facico | Chinese-Vicuna | 2023-03 |

| Chinese-Vicuna | 7B | Decoder | 中文 | ckpt | Facico | Chinese-Vicuna | 2023-03 |

| ChatYuan-V2 | 0.7B | Encoder-Decder | 中英文 | ckpt | 元语智能 | ChatYuan | 2023-03 |

| Chinese-LLaMA-Alpaca | 7B | Decoder | 中文 | lora-ckpt | Yiming Cui | Chinese-LLaMA-Alpaca | 2023-03 |

| Luotuo | 7B | Decoder | 中文 | ckpt | 商汤科技&华中师范大学 | Chinese-alpaca-lora | 2023-03 |

| BELLE-LLAMA | 7B | Decoder | 中英文 | ckpt | 贝壳 | BELLE | 2023-03 |

| BELLE-BLOOM | 7B | Decoder | 中英文 | ckpt | 贝壳 | BELLE | 2023-03 |

| ChatGLM-6B | 6B | Decoder | 中英双语 | ckpt | 清华大学 | ChatGLM-6B | 2023-03 |

| ChatRWKV | 7B | RNN | 中/英文 | ckpt | BlinkDL | ChatRWKV | 2023-01 |

预训练模型的方法改进

掩码方式的转变

位置编码的转变

LN 的位置变化

MoE层的使用

🇨🇳中文预训练模型研究进展&整理

http://example.com/2023/03/21/🇨🇳中文预训练模型研究进展&整理/